DMEXCO Marketing Precap Part 3: Data-Trends 2021

Lange bewährte Ansätze der Datenerfassung werden mittelfristig nicht mehr den gewünschten Erfolg bringen. Marco Szeidenleder, Gründer und Managing Partner von Pandata, zeigt uns, welche Data-Trends uns 2021 erwarten.

Die Auswertung von Daten für Marketingzwecke wird zunehmend schwieriger. Das allgemein steigende Bewusstsein für den Schutz von Personendaten führt zu weitreichenden Veränderungen der technischen und gesetzlichen Gegebenheiten in Bezug auf Datenerfassung und -nutzung. Mittlerweile setzt ein großer Teil der Webseitennutzer Adblocker ein, die eine Datenerfassung mit bisherigen Methoden effektiv verhindern. Das geht soweit, dass bestimmte Browser oder Browser-Plug-ins gar gezielt falsche Daten an Marketing-Tools schicken.

Auf der anderen Seite positionieren sich Browser-Hersteller im Markt mit Maßnahmenpaketen gegen die Nutzerdatenerfassung. Mozillas Firefox mit der sogenannten „Enhanced Tracking Protection“ und Apples Safari mit der „Intelligent Tracking Protection“ sind dabei die Vorreiter. Auch die Anbieter großer Plattformen gehen zunehmend gegen die Datennutzung vor. So hat beispielsweise Facebook den Funktionsumfang der API vor einiger Zeit deutlich verringert und auch die Nutzeridentifikation auf iOS wird durch neue Einschränkungen der Geräte-ID für Werbetreibende schwieriger.

Die europäische Gesetzgebung erfordert mittlerweile nicht nur die Abfrage der Zustimmung des Nutzers zu praktisch jeglicher Datenerfassung, sondern erschwert auch die Nutzung von Lösungen von außerhalb der EU signifikant. Insbesondere die Einstufung der USA als datenunsicheres Land macht die Nutzung der geläufigsten Tools wie Google Analytics zu einer rechtlich gefährlichen Grauzone.

Status Quo

Cookies sind in den letzten Jahren zum Inbegriff für illegitime Datennutzung geworden. Auch wenn dieses Urgestein der Internettechnologie in erster Linie nur eine von mehreren Möglichkeiten darstellt, Daten im Browser zu speichern, ist praktisch nur damit eine Nutzeridentifikation über Webseiten hinweg möglich – und damit Werbeanzeigen, die den Nutzer „verfolgen“. Momentan gibt es noch einige Workarounds, die versuchen, den Status Quo zu erhalten. Dazu gehören zum Beispiel technische Kniffe, um Cookie-Laufzeiten zu verlängern, oder andere Identifizierungsverfahren wie das sogenannte Fingerprinting.

Bei Letzterem wird aus den Browser-Daten des Nutzers eine eindeutige Kennung generiert, über die dieser identifiziert werden kann. Diese Workarounds können momentan noch effektiv sein, werden allerdings über kurz oder lang von Browser-Herstellern verhindert werden. Neben technischen Maßnahmen werden auch sogenannte „Dark Patterns“, also Versuche, den Benutzer durch irreführende Webseitengestaltung zur Zustimmung der Datenerfassung zu bewegen, in Zukunft eher zu den digitalen Taschenspielertricks zählen und damit verschwinden.

Momentan findet die Nutzerdatenerfassung noch fast ausschließlich im Browser des Webseitenbesuchers statt. Dieser Ansatz bot bisher einige Vorteile, wie den ungehinderten Zugriff auf Cookies und die unkomplizierte Implementierung von Tracking-Codes. Mittlerweile wird das sogenannte clientseitige Tracking aufgrund der oben genannten Punkte immer schwieriger und lückenhafter. Hauptgrund dafür ist, dass die Datenerfassung über den Browser vollständig der Art des Umgangs mit Daten durch den Browser ausgeliefert ist. Die Lösung für einige in diesem Zusammenhang entstehende Probleme ist die Verlagerung der Datenerfassung auf den Server.

Server-side Tracking

Auch wenn das sogenannte Server-side-Tracking schon so alt ist wie die Webanalyse selbst, so gewinnt der Ansatz durch die aktuellen Entwicklungen deutlich an Relevanz und wird voraussichtlich eines der großen Marketing-Buzzwords des kommenden Jahres. Das funktioniert wie folgt: Beim Besuch einer Webseite wird diese von einem Webserver abgerufen. Der Webserver „weiß“ daher immer zu einem gewissen Grad über das Verhalten des Nutzers auf der Webseite. Server-side-Tracking macht sich diese unumgängliche Verbindung zunutze. Die Daten werden dann nicht vom Browser des Nutzers (dem Client) gesendet, sondern direkt vom Webserver an die Analytics-Tools geschickt.

Da der Browser gar nicht mit der Datenerfassung in Berührung kommt, ist diese für den Benutzer vollkommen unsichtbar. Auf diese Weise entzieht sich serverseitiges Tracking dem Einfluss der Adblocker und auch Browser-Maßnahmen wie ETP und ITP. Server-Side Tracking bietet so eine nahezu hundertprozentige Datenqualität. Dadurch, dass das Tracking keinen Berührungspunkt mit dem Browser hat, bleiben nicht nur Seitenladezeiten unbeeinflusst, es ist auch möglich, Tracking-Daten während der Erfassung anzureichern.

So können kritische Daten wie Produkt-Margen in Echtzeit in das Tracking und auch in die Kommunikation mit Marketingkanälen einfließen.

Bisher haben die deutlich komplexere Implementierung und die eingeschränkten Möglichkeiten, auf Cookies zuzugreifen, eine weitere Verbreitung des Ansatzes verhindert. Letzteres wird in naher Zukunft deutlich weniger relevant sein, für Ersteres gibt es mittlerweile eine Reihe von Tools, die die Implementierung zumindest deutlich vereinfachen.

Server-side Tagging

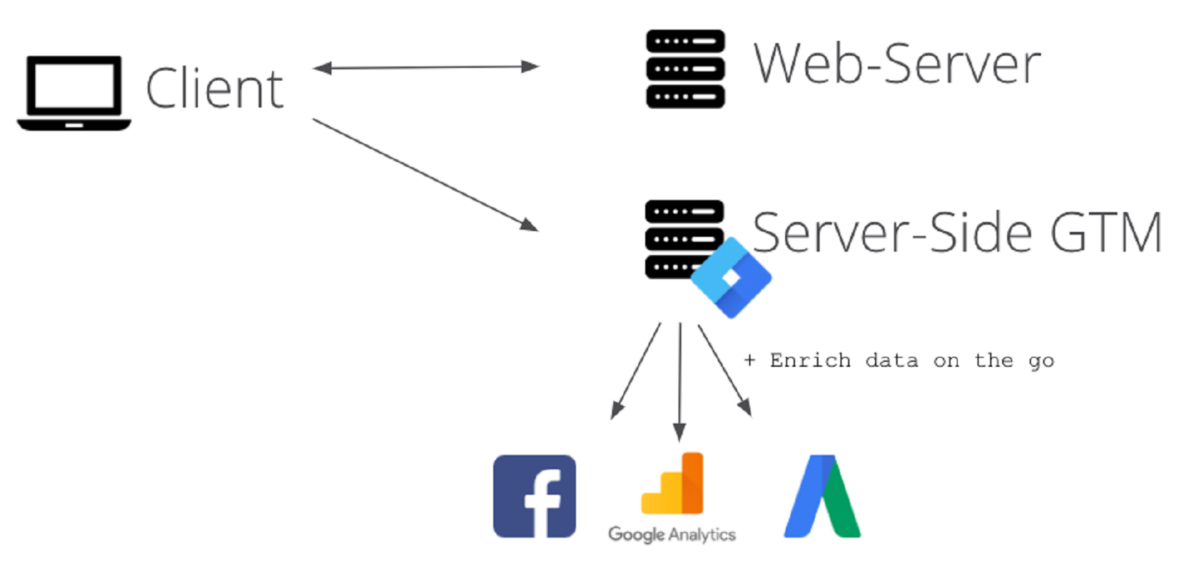

Für einige Tool-Anbieter von Tracking gehört Server-side Tracking schon lange zum festen Bestandteil des Produkts. Auch wenn die Google-Lösung noch relativ neu auf dem Markt ist, deuten zum einen die Marktmacht von Google und zum anderen der innovative hybride Ansatz schon jetzt auf eine große zukünftige Verbreitung hin. Das Server-side Tagging genannte Verfahren stellt quasi eine Mischung aus serverseitigem und clientseitigem Tracking dar: Weiterhin werden Daten klassisch im Browser erhoben. Diese werden jedoch nicht direkt an die Analyse-Tools geschickt, sondern zur weiteren Verteilung an eine selbstgehostete Instanz des Google Tag Managers geleitet.

Damit sind zumindest ein paar der Vorteile des serverseitigen Tracking sofort realisierbar, viel wichtiger jedoch stellt es einen einfachen Einstieg in die Welt des Server-side Tracking dar. Der Google Tag Manager für Server-side ist auch in der Lage, Tracking-Daten direkt vom WebServer oder aus anderen Quellen (wie CRM-System, Backend etc.) entgegenzunehmen, und kann so schrittweise die Datenerfassung über den Browser reduzieren.

Serverseitiges Tracking entbindet nicht von den Pflichten der DSGVO und so wird auch weiterhin eine Zustimmung zur Datenerfassung erforderlich sein. Auch wenn in Zukunft wahrscheinlich insgesamt weniger Benutzer erfasst werden, so wird dies vermutlich mit höherer Qualität geschehen. Klar kommunizierte Datenethik wird dabei eine größere Rolle spielen und zum festen Bestandteil der Corporate Social Responsibility werden. Benutzer werden potenziell bereit sein, einer Datenerfassung zuzustimmen, wenn sie verstehen, wie und wozu die Daten genutzt werden.

Cloud Data Warehousing

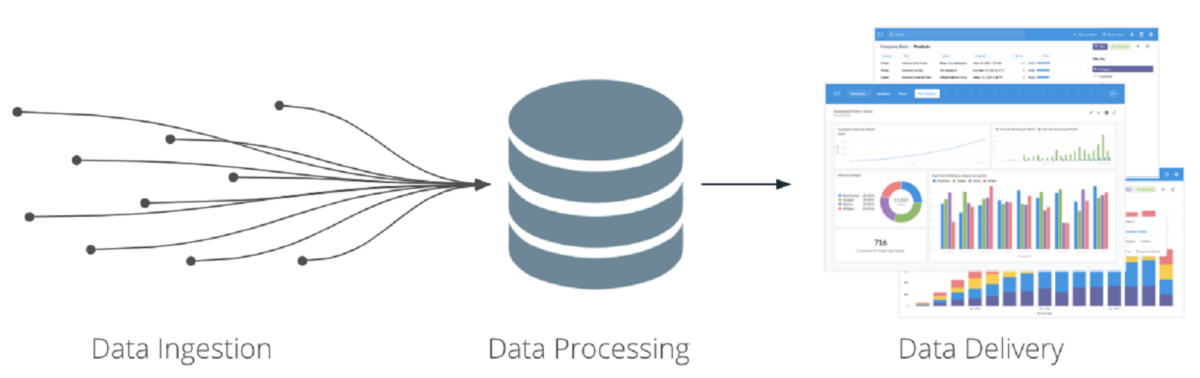

Mit der Verlagerung der Datenerfassung weg vom Browser werden sich auch die Technologien und Methoden zur Datenverarbeitung im Marketing verändern und inhaltlich näher an die Themenkomplexe der Business Intelligence und Data Science rücken. Zudem wird mehr Vernetzung zwischen technischen Systemen notwendig sein.

Allein um der DSGVO gerecht zu werden, müssen Unternehmen in der Lage sein, Daten eines Benutzers ganzheitlich über mehrere Systeme hinweg zu löschen. Darüber hinaus werden einige Use Cases erst durch die Zusammenführung von Daten aus verschiedenen Systemen überhaupt möglich. Herzstück dieses Prozesses wird ein flexibles und skalierbares Data Warehouse sein.

Mittlerweile gibt es einen klaren Trend in Richtung von Cloud-Systemen wie Google BigQuery zur Umsetzung eines flexiblen Data Warehouse. Dabei stehen hochperformante Systeme zu vergleichsweise extrem geringen Kosten zur Verfügung. Die reinen Infrastrukturkosten eines Data Warehouse auf Google BigQuery, einschließlich komplexer Attributionslogik, betragen selbst für einen großen Online-Handel nur ein bis zwei Euro pro Tag.

Weitere Vorteile ergeben sich durch die zunehmende Integration der Plattformen. So ist es bei BigQuery bereits möglich, einige Datenquellen ohne Integrationsaufwand direkt anzuzapfen, zum Beispiel Google Ads oder YouTube, und mit der zunehmenden Verbreitung von Google Analytics 4 (GA4) stehen nun sogar Rohdaten ohne 360-Lizenz zur Verfügung.

Vor allem große Unternehmen haben häufig eine relativ starre Systemlandschaft, die schon seit vielen Jahren besteht. Diese hat für viele Anwendungen weiterhin ihre Daseinsberechtigung, ist allerdings oft den gestiegenen Anforderungen an die Flexibilität und Skalierbarkeit moderner Datenanwendungen nicht gewachsen. Wichtig sind die unkomplizierte Integration neuer Datenquellen und neben der klassischen Analyse die Möglichkeit, auch Drittsysteme flexibel mit Daten zu füttern.

Als organisatorische „Single Source of Truth“ hält das Data Warehouse auch die logischen Definitionen, auf denen weitere Datenanwendungen aufbauen, und vermeidet so, dass beispielsweise innerhalb eines Unternehmen mehrere Versionen des Customer Lifetime Value verwendet werden. Ein modernes Data Warehouse ist das stabile Fundament für Data-Science- und Machine-Learning-Anwendungen.

Data-Science-Ansätze

Nachdem der Hype-Zyklus für Data Science seinem Ende zugeht, setzt langsam die tatsächliche Operationalisierung entsprechender Ansätze ein. Ein Beispiel dafür, das schon jetzt auf dem Buzzword-Radar für 2021 auftaucht, ist das sogenannte Marketing Mix Modelling. Dabei wird der Einfluss von Marketingmaßnahmen und äußeren Umständen auf eine abhängige Variable ermittelt, zum Beispiel Verkäufe.

Als Ausgangsdaten dienen Produkt- und Kampagnendaten, Marketingausgaben, Informationen über Saisonalitäten bis hin zu makroökonomischen Daten. Neben Informationen wie dem Grenznutzen einzelner Kampagnen – „Ab wann ergibt es keinen Sinn mehr, noch mehr Geld in eine Kampagne zu investieren?“ –, kann das Modell algorithmisch die Auswirkung unterschiedlicher Budgetverteilungen auf die Verkäufe berechnen und Entscheidungen in der Budgetallokation unterstützen.

Fazit

Weitreichende Veränderungen machen ein Umdenken in der Datenerfassung notwendig. Einige der gewohnten und lang bewährten Ansätze werden mittelfristig nicht mehr den gewünschten Erfolg bringen. Vor diesem Hintergrund entsteht zum einen eine Verlagerung der Datenerfassung vom Client zum Server und zum anderen wird der Dateninfrastruktur im Hintergrund mehr Bedeutung für das Marketing zukommen. Bei sauberer Datenerfassung und entsprechender Dateninfrastruktur kann es dann auch sinnvoll werden, statistische Methoden zur Unterstützung von Marketing-Entscheidungen heranzuziehen.